王选所语言计算与互联网挖掘实验室学生参加 ACL 2024

发布时间:2024-09-05

发布时间:2024-09-05

计算语言学协会年会(Annual Meeting of the Association for Computational Linguistics)是自然语言处理与计算语言学领域最高级别的学术会议,由国际计算语言学协会主办,并被中国计算机学会(CCF)推荐为人工智能领域的A类国际会议。今年计算语言学协会年会于2024年8月11日至16日在泰国曼谷举行。会议期间,来自王选所语言计算与互联网挖掘实验室的同学们就他们的研究成果进行了展示,并与国际同行进行了学术交流。

同学们在会场合照

黄柏舟同学做海报展示

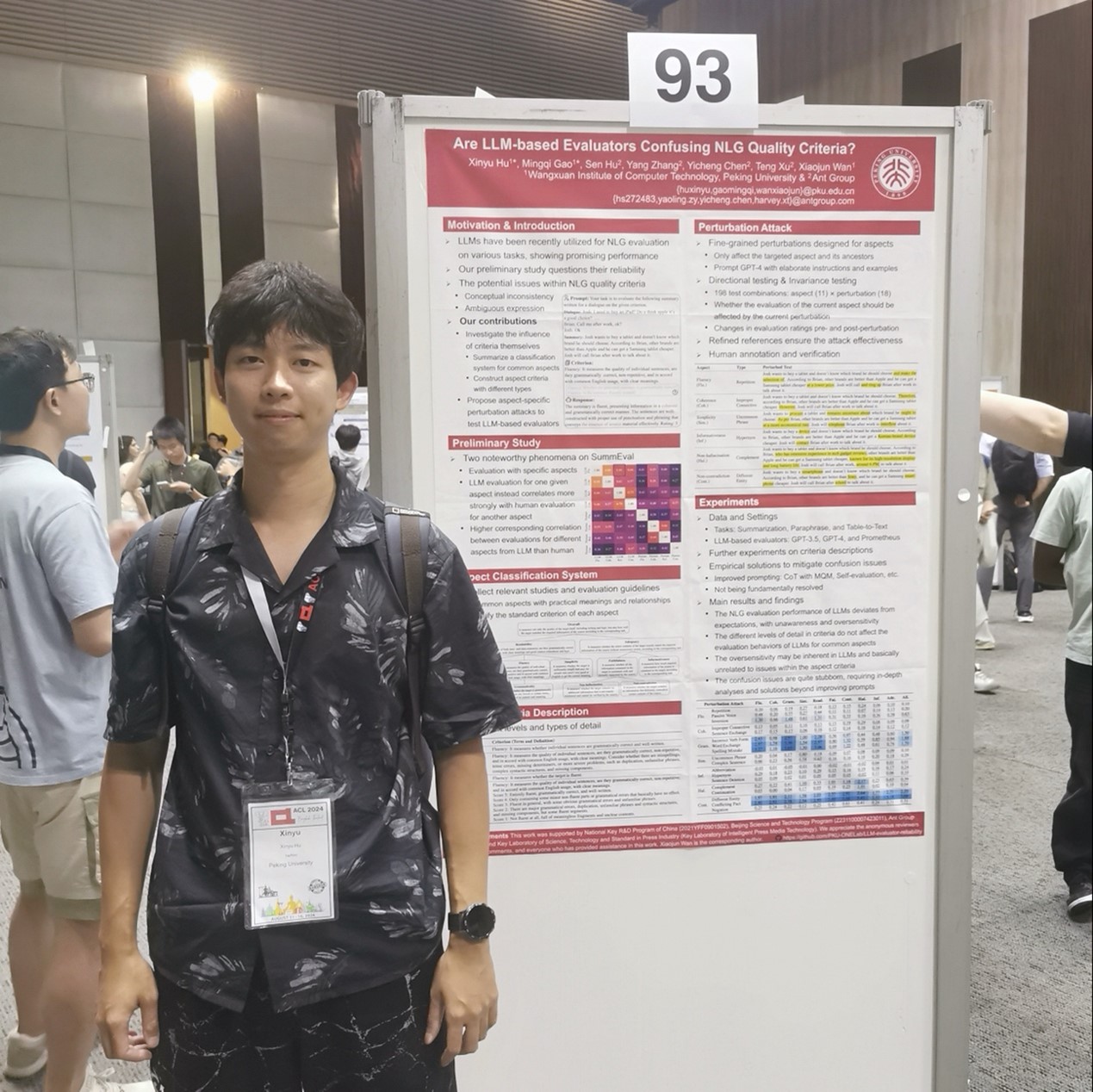

胡新宇同学做海报展示

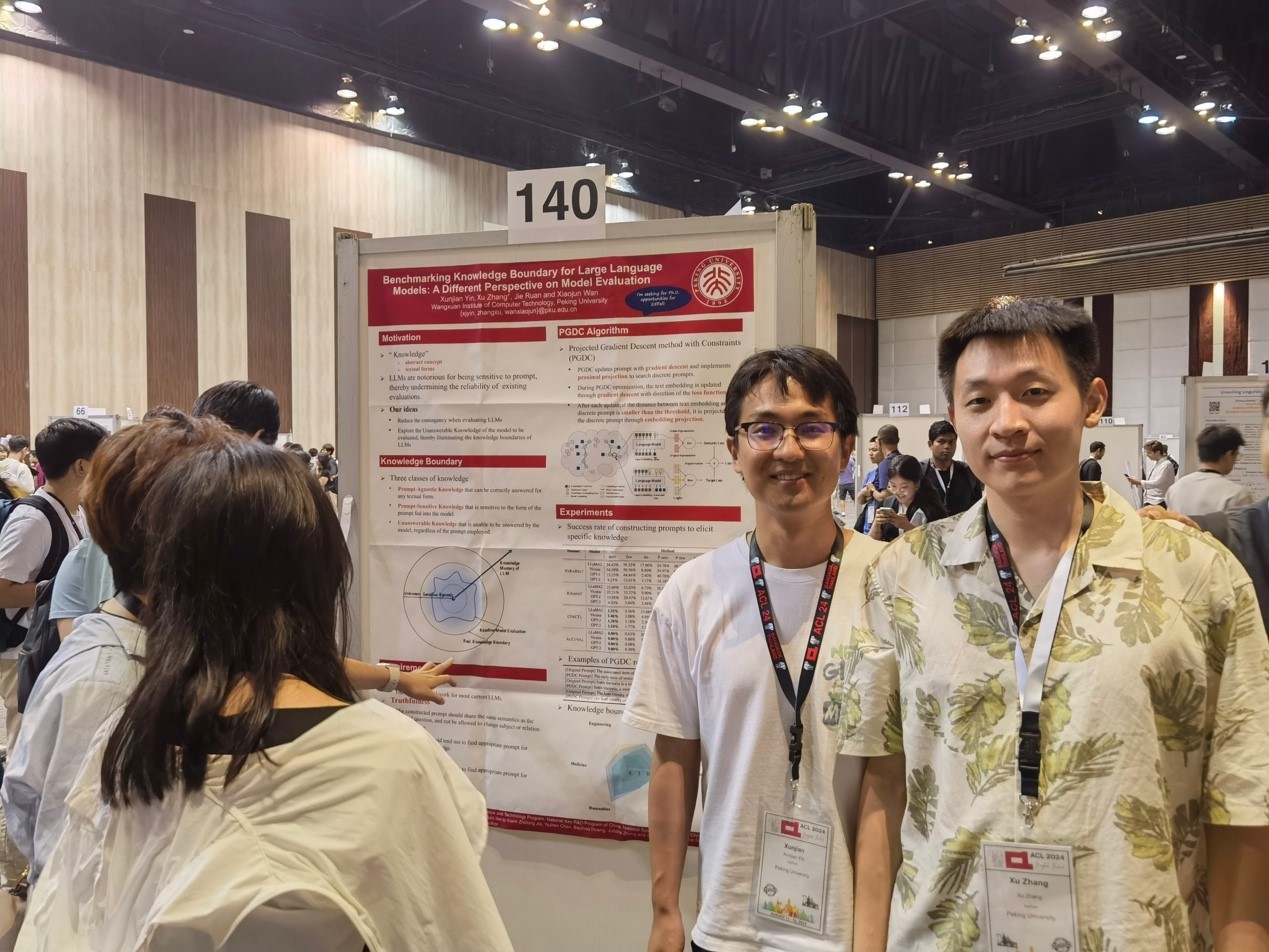

尹训健和张栩同学做海报展示

王选所语言计算与互联网挖掘实验室的研究生在ACL2024上发表的论文信息如下:

Xunjian Yin, Xu Zhang, Jie Ruan, Xiaojun Wan. Benchmarking knowledge boundary for large language model: A different perspective on model evaluation.

近年来,大型语言模型的发展取得了显著进展,在各种任务中表现出色。为了评估语言模型的知识能力,先前的研究提出了基于问答对的众多基准。然而,我们认为使用固定问题或有限的复述作为查询来评估语言模型是不可靠且不全面的,因为语言模型对提示词非常敏感。因此,我们引入了一个新概念,称为知识边界,以涵盖语言模型中与提示词无关和与提示词相关的知识。知识边界在语言模型评估中避免了提示词敏感性,使其更加可靠和稳健。为了探索给定模型的知识边界,我们提出了一种具有语义约束的投影梯度下降方法,这是一种新算法,旨在为每个知识点识别最佳提示词。实验表明,与现有方法相比,我们的算法在计算知识边界方面表现更优。此外,我们还在多个领域中使用知识边界评估了多种语言模型的能力。

Xinyu Hu, Mingqi Gao, Sen Hu, Yang Zhang, Yicheng Chen, Teng Xu, Xiaojun Wan. Are LLM-based Evaluators Confusing NLG Quality Criteria?

一些先前的研究表明,大型语言模型在不同任务的自然语言生成评估中表现良好。然而,我们发现大型语言模型似乎会混淆不同的评估标准,这降低了其可靠性。为了进一步验证这一点,我们首先考虑避免现有自然语言生成质量标准本身存在的不一致概念化和模糊表达问题。因此,我们总结了一套明确的分层分类体系,涵盖了先前研究中涉及的11个常见方面及其对应的不同标准。受行为测试的启发,我们精心设计了18种针对不同方面的扰动攻击,以对不同大型语言模型的评估行为进行细粒度分析。我们还在分类体系的指导之外进行了人工标注,以验证这些扰动的影响。实验结果揭示了大型语言模型固有的混淆问题以及其他值得注意的现象,这表明需要进一步研究和改进基于大型语言模型的评估方法。

Baizhou Huang, Shuai Lu, Xiaojun Wan, Nan Duan. Enhancing Large Language Models in Coding Through Multi-Perspective Self-Consistency.

大型语言模型在代码生成方面展现了出色的能力。然而,想要一次性生成正确的解决方案仍然是一个挑战。之前的研究利用软件工程中的验证属性,以多数投票的方式对解决方案进行验证和重新排序。但其背后的假设是,生成的验证属性质量优于解决方案,这一假设并不总是成立。在本文中,我们将它们视为语言模型推理过程的不同视角,并提出了多视角自洽性(MPSC)框架,结合了来自多个视角输出的内外一致性。具体而言,我们提示大型语言模型从三种视角(解决方案、规格说明和测试用例)生成多样化的输出,构建了一个三部图。通过两种一致性度量函数,我们将内外一致性信息嵌入到图中。然后,通过分析图来确定解决方案的最优选择。MPSC显著提升了基础模型(本文中的ChatGPT)在各种基准上的性能,包括HumanEval(+15.91%)、MBPP(+6.43%)和CodeContests(+9.37%),甚至超过了GPT-4。

上一篇 下一篇