王选所机器智能实验室参加ICLR 2025

2025年4月24日至4月28日,国际学习表征会议(International Conference on Learning Representations, ICLR)于新加坡召开。王选所机器智能实验室的博士研究生金阳、孙志诚、林琛果、徐沛然和本科实习生林宇辰参加了此次会议。

ICLR是人工智能领域的国际顶级会议。本次会议吸引了来自学术界、工业界研究者们参加。会议包括受邀演讲、口头报告、poster展示、workshop等环节。本次大会共提交了约11,500篇论文,录取率为32.08%。王选所机器智能实验室师生在本次ICLR会议中总共发表四篇论文。接收的论文信息如下:

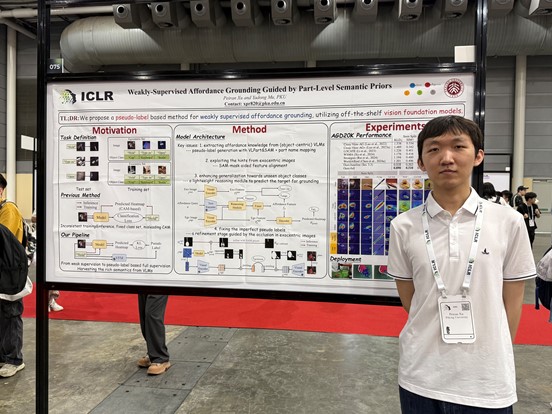

(一)Peiran Xu, Yadong Mu, "Weakly-Supervised Affordance Grounding Guided by Part-Level Semantic Priors", ICLR 2025

可供性(Affordance)是连接计算机视觉与具身智能的关键概念。近年来,一系列工作研究了基于图像的弱监督可供性检测任务,但普遍存在训练测试时计算流程不一致、预测热力图偏离目标区域等问题。本文提出一种基于视觉基础模型的可供性检测方法,有效地将基础模型中有关物体的先验知识迁移到有关动作的可供性任务中,实现了一种基于伪标签的监督训练策略。具体来说,本文建立一个从可供性类别和物体类别到物体部位名的映射,并通过SAM等现有模型为训练数据集构造可供性伪标签。同时,本文提出一个伪标签修正策略,一个物体掩码引导的跨视角对齐损失,和一个轻量级的可供性推理模块,充分利用了人和物体交互图片中隐式的可供性信息,并提高了模型在新物体类别上的泛化性。实验结果表明本文提出的方法取得了超越此前弱监督范式的性能表现。

(二)Yang Jin, Zhicheng Sun, Ningyuan Li, Kun Xu, Kun Xu, Hao Jiang, Nan Zhuang, Quzhe Huang, Yang Song, Yadong Mu, Zhouchen Lin, “Pyramidal Flow Matching for Efficient Video Generative Modeling”, ICLR 2025

本文提出了一种基于金字塔表征的流匹配生成式建模方法,显著提升了高维数据生成建模的训练效率。针对由视频和图像高维空间带来的海量训练资源和数据需求,设计了一种高效的金字塔流匹配生成算法。该框架将原始流匹配中的生成轨迹重新表示为多个不同的金字塔子阶段,并对轨迹前期的金字塔阶段进行高度压缩,极大地降低了其维度空间和计算复杂度。通过加入一些新颖的噪声修正设计,不同金字塔阶段的流轨迹之间能够彼此相互关联,并保持整体概率流的连续性。作为一种自回归式的生成建模框架,其使用统一的扩散Transformer 架构,以端到端训练的方式来优化不同的金字塔阶段。实验验证了金字塔流匹配可以在实现高质量视频、图像生成的前提下,极大地降低训练开销,为实现高效多模态生成建模提供了新的途径。

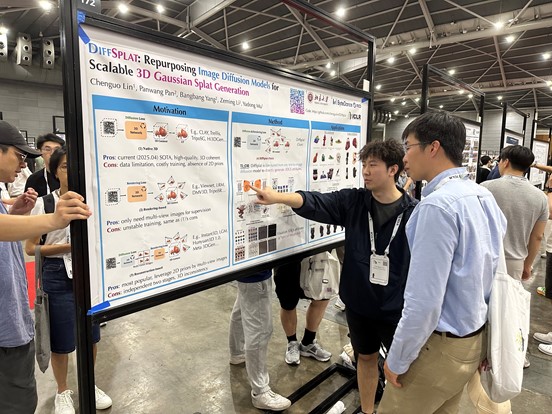

(三)Chenguo Lin, Panwang Pan, Bangbang Yang, Zeming Li, Yadong Mu, "DiffSplat: Repurposing Image Diffusion Models for Scalable 3D Gaussian Splat Generation", ICLR 2025

当前基于文本或单张图像的3D内容生成技术面临两大挑战:高质量3D数据集的匮乏与2D多视角生成的不一致性。为此,我们提出DiffSplat——一种通过驾驭大规模文生图扩散模型来原生生成3D高斯体的创新框架。该框架与现有3D生成模型的本质区别在于:其既能有效利用网络级规模的2D先验知识,又能在统一模型中保持3D一致性。为快速启动训练流程,我们设计了一种轻量级重建模型,可即时生成多视角高斯体网格以实现可扩展的数据集构建。除了在这些网格上应用常规扩散损失函数外,我们还创新性地引入了3D渲染损失函数,从而确保任意视角下的3D连贯性。得益于与图像扩散模型的兼容性,大量成熟的2D图像生成技术得以无缝迁移至3D领域。大量实验证明,DiffSplat在文本/图像条件生成任务及下游应用中均展现出卓越性能。系统的消融研究不仅验证了每个关键设计决策的有效性,更为底层机制提供了深刻洞见。

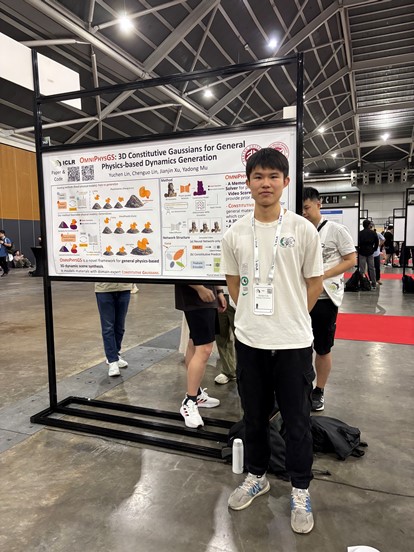

(四)Yuchen Lin, Chenguo Lin, Jianjin Xu, Yadong Mu, “OmniPhysGS: 3D Constitutive Gaussians for General Physics-based Dynamics Generation”, ICLR 2025

近年来,在三维资产的重建与生成方面取得了显著进展,涵盖静态场景以及具有物理交互的情况。为恢复三维资产的物理属性,现有方法通常假设所有材料属于某一预定义类别(例如弹性体)。然而,这种假设忽略了现实场景中多种异质对象的复杂组合,往往在面对更广泛种类的对象时,生成的动画缺乏物理真实感。为此,我们提出了 OmniPhysGS,用于合成由更通用对象组成的基于物理的三维动态场景。OmniPhysGS 的一个关键设计是将每个三维资产视为由多个“本构三维高斯体”组成。对于每个高斯体,其物理材料由一个包含 12 种物理专业子模型(如橡胶、金属、蜂蜜、水等)的集合来表示,从而大大增强了模型的灵活性。在实现中,我们通过用户指定的提示语来定义场景,并利用预训练的视频扩散模型来监督材料权重因子的估计。综合实验表明,该方法能够在更广泛的材料范围(包括弹性、黏弹性、塑性和流体物质)及其相互作用之间,实现更通用和更真实的物理动态表现。在视觉质量和文本对齐度等指标上,我们的方法相较现有方法提升了约 3% 到 16%。

上一篇 下一篇