王选所研究生参加MMM 2020

发布时间:2020-01-20

发布时间:2020-01-20

第26届国际多媒体建模会议(International Conference on Multimedia Modeling,简称MMM)于2020年1月5日至8日在韩国大田广域市举行。王选所硕士研究生王文光、田从州、张彤以及博士研究生黄志杰参加了此次会议。

MMM是面向研究人员和行业从业人员的国际领先会议,目的在于分享多媒体所有相关领域的新想法,原始研究结果和实际开发经验。会议接受报告原始调查结果的研究性论文以及报告新颖的应用的演示。

参会人员合影(左起:王文光、田从州、黄志杰、张彤)

王选所师生在本次会议上共发表7篇文章,包括6篇oral长文和1篇poster,并在会议上做了口头报告。论文具体信息如下:

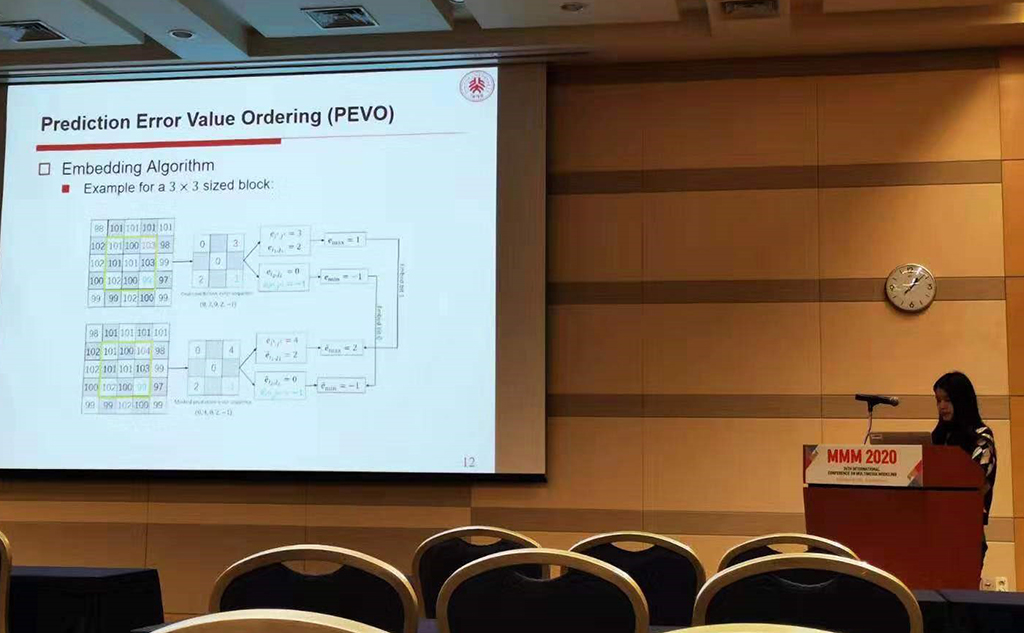

1. Zhang T, Li X, Qi W, et al. Prediction-Error Value Ordering for High-Fidelity Reversible Data Hiding[C]//International Conference on Multimedia Modeling. Springer, Cham, 2020: 317-328.

该论文提出了一种新的可逆信息隐藏方法,称为预测误差值排序(PEVO)。 PEVO的主要思想是通过将预测误差扩展(PEE)与最新的像素值排序技术(PVO)相结合,来利用预测误差的相互关系。具体而言,首先对图像块内的预测误差进行排序,然后预测并修改该块的最大和最小预测误差以进行数据嵌入。通过所提出的方案,更好地利用了图像冗余,并实现了良好的嵌入性能。

张彤同学做报告

2. Yunchang Li, Zhijie Huang, Jun Sun. An Efficient Encoding Method for Video Compositing in HEVC.

该论文提出了一种有效的视频融合方法,即使用传入的原始码流信息对融合视频的编码进行加速。根据视频帧是否被插入的视频所覆盖,我们将其分为了插入区域和非插入区域。针对插入区域,由于缩小视频并不会改变视频的时域与空域相关性,我们提出了能够克服网格非对齐问题的基于原始分辨率视频统计信息的预测模式决策算法。进一步地,我们利用了运动矢量信息来决策预测块的划分。针对非插入区域,视频内容保持完全一致。考虑到插入区域的编码可能会对非插入区域产生影响,我们对信息复用进行了充分地讨论,保证了信息重用后的编码质量。所提出的方法与传统方法相比,编码速度得到了有效提升

黄志杰同学代表李云畅同学做报告

3. Wenguang Wang, Zhouhui Lian, Yingmin Tang, Jianguo Xiao. DeepStroke: Understanding Glyph Structure with Semantic Segmentation and Tabu Search

该论文提出一种新的笔画提取框架,通过改进的语义分割模型DeepStroke分割笔画,通过禁忌搜索获取笔顺信息。论文提出的方法在精度提高的同时,大大减少了笔画拆解时间(每张图20-30s降低到120ms)。

王文光同学做口头报告

4. Zhijie Huang, Yunchang Li, Jun Sun. Efficient HEVC Downscale Transcoding Based on Coding Unit Information Mapping.

该论文提出了利用CU信息重用的下采样转码方法,通过利用原分辨率编码的CU深度信息和模式信息来加速当前分辨率视频编码,当前编码速度得到了极大提升,且质量损失不大。

黄志杰同学poster展示

5. Yafeng Zhou, Yongtao Wang, Zheqi He, Zhi Tang, Ching Y. Suen:Towards Accurate Panel Detection in Manga: A Combined Effort of CNN and Heuristics. MMM (1) 2020: 215-226.

分镜是漫画页面的基本元素,因此,分镜的检测是高级漫画内容理解的基础。现有的分镜检测方法可以分为基于启发式的方法和基于CNN(基于卷积神经网络)的方法。尽管前者可以准确地定位分镜,但是他们无法处理精巧的分镜,并且需要为每个新的困难案例花费大量精力来制定手工规则。相比之下,基于CNN的方法的检测结果可能是粗糙且不准确的。该论文利用CNN目标检测器来提出粗略的指导分镜,然后使用启发式方法来提出分镜候选对象,最后优化能量函数以选择最合理的候选对象。CNN可以确保对几乎所有类型的分镜进行大致的局部检测,而后续程序可以完善检测结果,并借助启发式方法和能量最小化功能,将检测到的分镜与地面真相之间的余量最小化。实验结果表明,所提出的方法在分镜检测F1得分和页面准确性方面优于以前的方法。

6. Congzhou Tian, Deshun Yang, and Xiaoou Chen. A Distinct Synthesizer Convolutional TasNet for Singing Voice Separation

该论文将时域分离网络conv-tasnet首次应用于人声伴奏分离任务上,并提出了不同的合成器的conv-tasnet进行人声伴奏分离,取得了更好的效果。

7. Congzhou Tian, Hangyu Li, Deshun Yang, and Xiaoou Chen. Gen-Res-Net: a Novel Generative Model for Singing Voice Separation

该论文提出了基于声谱图的人声伴奏分离网络Gen-Res-Net,在相同任务上击败了同样基于声谱图的分离网络U-Net。

上一篇 下一篇