计算机所师生参加AAAI2019

发布时间:2019-02-28

发布时间:2019-02-28

2019年1月28日至2月2日,计算机所赵东岩老师、连宙辉老师和高莘、仇立松、赵祈杰等同学前往美国夏威夷参加AAAI 2019(The Thirty-Second AAAI Conference on Artificial Intelligence)。该会议是美国人工智能协会的年度会议,是人工智能领域的顶级会议,受到学术界和工业界的极大关注。

计算机所师生在AAAI会场合影(第一排左起:钱瑞,江月,姚丽丽,连宙辉,赵东岩,赵祈杰,高莘;第二排左起:杨帅,王天明,仇立松,盛涛)

本次会议主题包括机器学习、自然语言处理、计算机视觉、人工智能应用、以及检索、规划、博弈论等传统人工智能研究方向,包含嘉宾演讲、口头报告、海报展示、讨论会等多个环节,给予参会人员充分的交流机会。

本届会议共收到有效投稿7700余篇,其中7095篇进入评审环节, 1150篇被录用,录取率为16.2%,达近年最低。计算机所师生在本次会议上共发表了10篇论文,并在会议上做了口头报告和海报展示。论文信息如下:

[1] Shen Gao, Xiuying Chen, Piji Li, Zhaochun Ren, Lidong Bing, Dongyan Zhao, Rui Yan. Abstractive Text Summarization by Incorporating Reader Comments.

为解决生成式摘要常无法抓住文章主要观点的问题,本文提出利用读者评论辅助摘要生成工作,并加入对抗学习方法促使生成的摘要和读者的关注点尽可能相似。实验结果表明:无论是自动指标还是人工测评,本文模型都有显著的提高。

高莘做口头报告

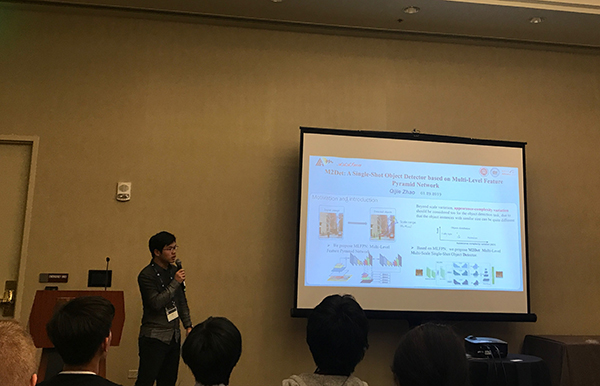

[2] Qijie Zhao, Tao Sheng, Yongtao Wang, Zhi Tang, Ying Chen, Ling Cai and Haibin Ling M2Det: A Single-Shot Object Detector based on Multi-Level Feature Pyramid Network

本文提出了多级金字塔网络,并基于此提出了一个端到端的性能强悍的单步目标检测器M2Det,M2Det在浅层的金字塔网络里能学习到更多有利于简单物体检测的特征,在深层的金字塔网络里能学习到更多有利于复杂物体检测的特征。在基准测试榜单MS-COCO数据集上,M2Det取得了单目标检测器的新的最高结果。

赵祈杰做口头报告

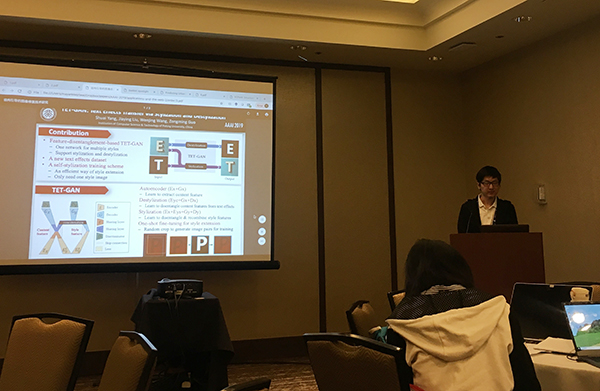

[3] Shuai Yang, Jiaying Liu, Wenjing Wang, and Zongming Guo. TET-GAN: Text Effects Transfer via Stylization and Destylization.

本文提出了文字风格化网络TET-GAN。首先建立了字效数据库,然后训练网络对艺术字图片进行字形特征和字效特征的提取,通过对字形特征和字效特征的组合,TET-GAN能完成文字特效迁移和艺术字去风格化两个任务。

杨帅做口头报告

[4] Tianming Wang and Xiaojun Wan. Hierarchical Attention Networks for Sentence Ordering.

针对句子排序任务,本文提出了一个基于层次式注意力的模型:在利用句子 中的关键词线索的同时也对句子间的依赖关系进行建模。结果显示该方法能有效地提升结果。

王天明做口头报告

[5] Rui Qian, Yunchao Wei, Honghui Shi, Jiachen Li, Jiaying Liu, and Thomas Huang. "Weakly Supervised Scene Parsing with Point-based Distance Metric Learning"

本文提出了一种弱监督场景分割的方法,对于每个场景中的每个物体实例只需要一个像素的监督信息来进行模型的训练。模型利用跨图片的语义联系很好的提高了效果。

钱瑞做口头报告

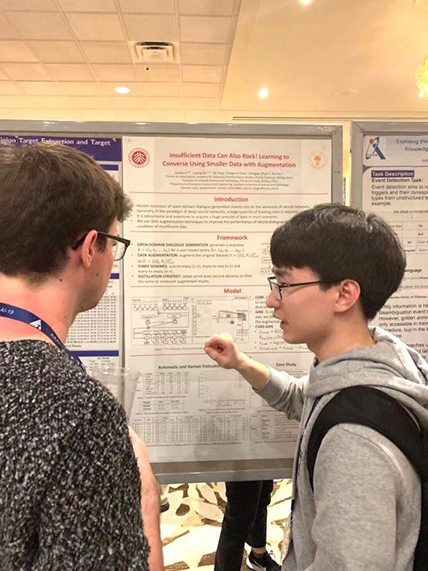

[6] Juntao Li, Lisong Qiu, Bo Tang, Min Chen, Dongyan Zhao and Rui Yan. Insufficient Data Can Also Rock!Learning to Converse Using Smaller Data with Augmentation.

基于深度学习模型的对话系统常常会面临数据稀疏性问题,这限制了部分场景下对话系统的表现。在本文中,研究人员创新地提出了结合条件变分自编码器和对抗训练的对话数据增强方法,并研究了不同的数据生成框架与过滤策略。实验结果表明了本文所提出方法的有效性。

仇立松做海报展示

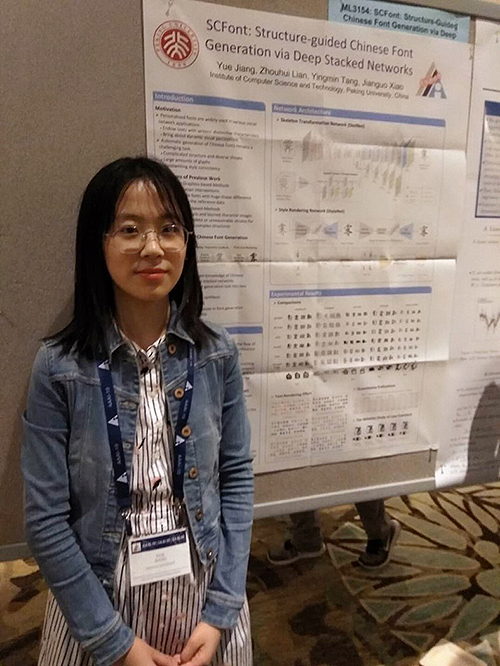

[7] Yue Jiang, Zhouhui Lian, Yingmin Tang, Jianguo Xiao. SCFont: Structure-guided Chinese Font Generation via Deep Stacked Networks.

本文提出了一种中文字体自动生成方法,将汉字领域知识和深度神经网络结合,同时保证字形结构的正确性和书写风格的相似性。首先通过多级网络结构将汉字从参考风格迁移到目标风格,然后通过渲染笔画风格细节,最后得到完整的中文字库。

江月做海报展示

[8] Yuxuan Lai, Yansong Feng, Xiaohan Yu, Zheng Wang, Kun Xu, Dongyan Zhao. Lattice CNNs for Matching Based Chinese Question Answering.

长期以来,关于事件抽取的研究受训练实例数据集的数量和质量的双重影响。而现有数据库需人工生成,常因工程量大导致样本量较少。为解决这一问题,本文基于远程监督方法提出利用现有结构化知识库或表格中从未标记的文本自动创建活动通知的模型。实验结果表明,该模型可以生成大量高质量的训练实例。

[9] Juntao Li, Lidong Bing, Lisong Qiu, Min Chen, Dongyan Zhao, Rui Yan. Learning to Write Stories with Thematic Consistency and Wording Novelty.

计算机自动创作内容一致、用词新颖的故事是一个难题。虽然之前的相关研究已经取得了引人注目的成果,但现有方法自动生成的故事,在主旨一致性和用词的新颖性上仍不尽如人意。在本文中,研究人员提出了结合条件变分自编码器和缓存机制来生成故事。实验结果表明,无论是自动指标还是人工测评,本文的模型都有显著的提高。

[10] Lili Yao, Nanyun Peng, Ralph Weischedel, Kevin Knight, Dongyan Zhao and Rui Yan. Plan-And-Write: Towards Better Automatic Storytelling.

自动故事创作是自然语言处理领域的一个难题。现有的模型方法仅局限于情节的生成而缺少对整体内容的规划。针对开放域故事生成任务,本文创新地提出了层次化的先起草后生成(plan-and-write)的故事生成框架,并对两种故事线生成方法进行了对比研究。实验结果表明,本文提出的方法有助于生成表达多样且主旨一致的故事内容。

[11] Yanghao Li, Sijie Song, Yuqi Li, and Jiaying Liu. Temporal Bilinear Networks for Video Action Recognition

本文提出了一种时序双线性网络结构,在网络中对于时序中的多帧进行建模,抽取时序相关性特征,并利用基于分解的双线性网络和bottleneck结构,控制网络的参数和计算复杂度。本文的方法在多个动作识别数据集上对比基准方法取得了更好的效果。

上一篇 下一篇