王选所师生参加 ACM MM 2024

2024年10月28日至11月1日,第32届ACM国际多媒体会议(The 32nd ACM International Conference on Multimedia, ACM MM 2024)在澳大利亚墨尔本召开。王选所郭宗明研究员、刘洋助理教授、贾川民助理教授和博士生刘旸、匡浩玮、叶枫、硕士生王梓烁参加了此次会议。

自 1993 年以来,ACM国际多媒体会议一直汇聚来自学术界和工业界的全球研究人员和从业人员,展示他们的创新研究并讨论多媒体领域的最新进展。本次会议收到了 4,300 多份提交,接受了 1,100 多篇论文。会议包括了口头报告、海报展示、workshops、tutorials和industry program等环节。

王选所师生在会场合影(左起:刘旸,叶枫,刘洋,匡浩玮,郭宗明,王梓烁,贾川民)

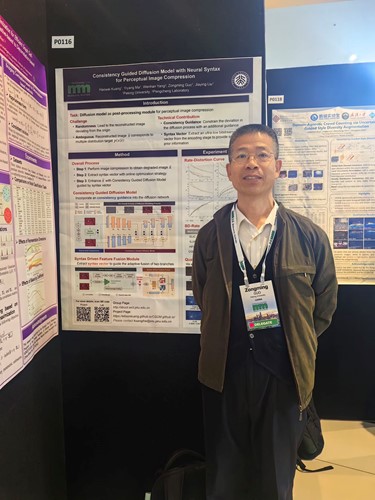

郭宗明研究员参加会议

刘洋助理教授参加会议

贾川民助理教授参加会议

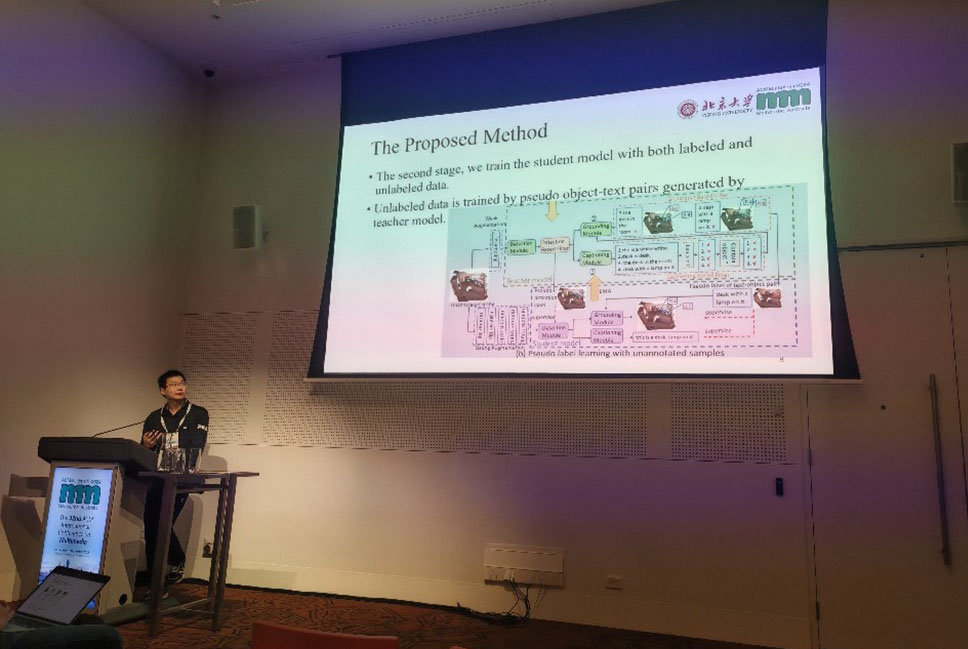

叶枫同学进行口头汇报

刘旸同学进行口头汇报

匡浩玮同学进行海报展示

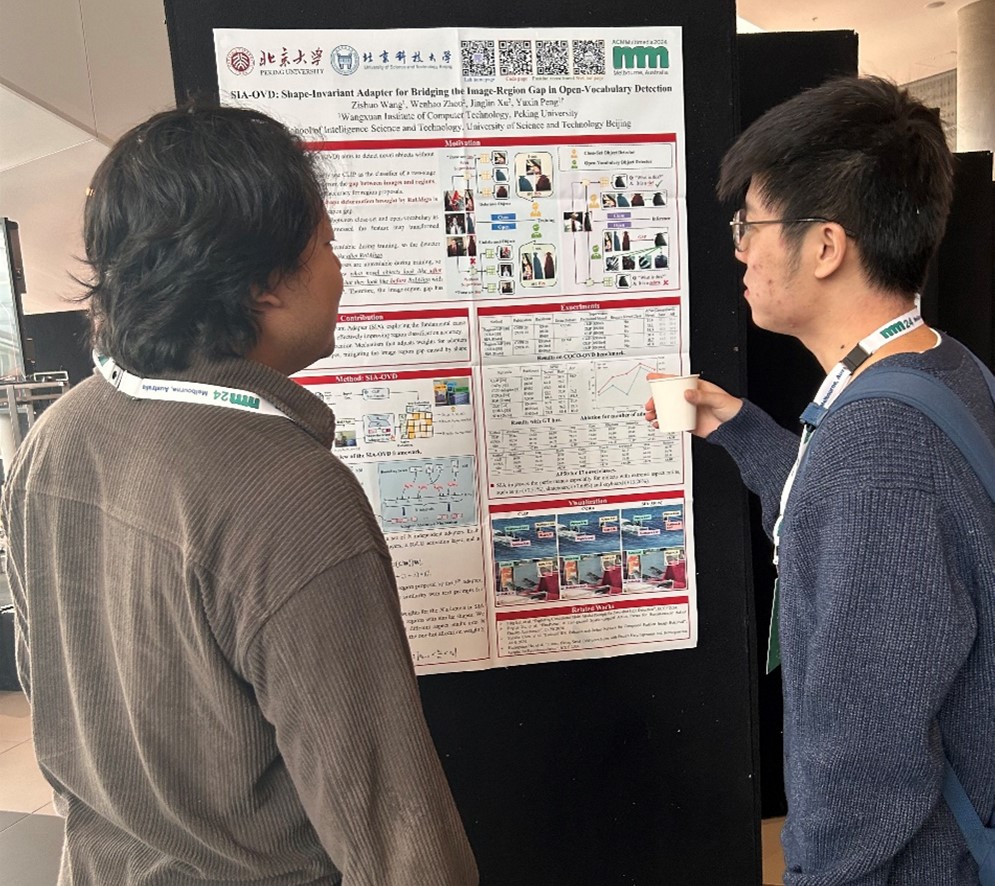

王梓烁同学进行海报展示

王选所师生发表论文12篇,具体信息如下:

1. Haowei Kuang, Yiyang Ma, Wenhan Yang, Zongming Guo, and Jiaying Liu. Consistency Guided Diffusion Model with Neural Syntax for Perceptual Image Compression. ACM MM 2024.

本工作为面向人眼视觉的图像压缩设计了一个基于扩散模型的后处理网络,提出了利用一致性引导特征约束扩散过程的随机性的策略,并在此基础上设计了以编码端极低码流语义向量信息为输入的语法驱动特征融合模块,缓解了优化目标的不适定性。实验结果表明,该后处理模块能够显著提升重建图像的视觉质量。

2. Xiang Gao and Jiaying Liu. FBSDiff: Plug-and-Play Frequency Band Substitution of Diffusion Features for Highly Controllable Text-Driven Image Translation. ACM MM 2024.

本工作从频域视角为文生图扩散模型提出了一个新颖高效的图像提示方法,提出利用扩散模型隐空间特征的不同DCT频带解耦并建模提示图像对生成图像不同类型的引导因子,并据此设计了即插即用的频带置换机制,在无需模型训练及微调的情况下实现了对提示图像多样化引导因子及引导强度的灵活控制。

3. Yifan Li, Yuhang Bai, Shuai Yang, and Jiaying Liu. COCO-LC: Colorfulness Controllable Language-based Colorization. ACM MM 2024.

本工作致力于探索基于文本引导的图像着色问题,并提出了一种简单灵活的颜色丰富程度控制机制,满足了不同用户审美的需要。研究提出了一种多阶段着色框架,并设计了多尺度的外部信息约束注入方法。实验结果表明,该方法可以有效提升着色结果的视觉质量,并显著减少了颜色溢出、伪影、与文本不匹配等错误情况。

4. Minghang Zheng, Jiahua Zhang, Qingchao Chen, Yuxin Peng, Yang Liu. ResVG: Enhancing Relation and Semantic Understanding in Multiple Instances for Visual Grounding. ACM MM 2024.

本工作提出了ResVG 模型,旨在解决视觉定位任务中针对多个实例干扰的挑战。该模型通过以下两种方式来增强其对物体语义和空间关系的理解:(1)将文本查询中提取的语义信息注入模型中,以提高对目标物体的理解;(2)通过数据增强方法生成包含多个同类物体的图像和伪查询,以增加训练数据。实验结果表明,ResVG 模型显著提高了视觉定位任务的性能,特别是在多实例干扰场景下。

5. Zhaoda Ye, Xinhan Zheng, Yang Liu, Yuxin Peng. RelScene: A Benchmark and baseline for Spatial Relations in text-driven 3D Scene Generation. ACM MM 2024.

本工作提出了一个基于文本描述的3D室内场景生成方法,旨在自动生成和安排物体,形成准确捕捉文本描述语义的3D场景。为了解决现有方法中缺乏维持空间关系一致性的问题,论文提出了一个新的数据集和基准,包含3D场景、文本描述、物体空间关系注释和模板/自由形式的自然语言描述。论文还提出了一种伪描述特征生成方法和对齐潜在空间,以提高方法在生成正确空间关系方面的能力。

6. Feng Ye, Li Zhang, Chuanmin Jia. Deep Video Compression with Scaled Hierarchical Bi–directional Motion Model. ACM MM 2024.

本工作提出了一个新的视频压缩模型,称为Scaled Hierarchical Bi-directional Prediction Structure,旨在有效地捕捉帧之间的时间相关性。该模型通过参数共享的运动编解码器和高效的信息融合策略来获得更精确的预测特征。同时,引入了可靠的运动建模概念来评估参考信息的有效性。实验结果表明,该模型在编码效率方面优于现有的最佳双向神经视频压缩模型,并被采用为MPAI EEV标准的参考模型。

7. Zishuo Wang, Wenhao Zhou, Jinglin Xu and Yuxin Peng. SIA-OVD: Shape-Invariant Adapter for Bridging the Image-Region Gap in Open-Vocabulary Detection. ACM MM 2024.

本工作提出了一个新的方法,称为SIA-OVD,旨在解决开启词汇检测(OVD)中图像和区域表示之间的差距。SIA-OVD 通过学习不同形状区域的特征适配器和设计适配器分配机制来提高区域分类准确率。实验结果表明,SIA-OVD 在 COCO-OVD 基准上取得了显著的改进。

8. Zichen Liu, Yuxin Peng and Jiahuan Zhou. InsVP: Efficient Instance Visual Prompting from Image Itself. ACM MM 2024.

本工作提出了一个实例视觉提示(Instance Visual Prompting,InsVP)方法,旨在提高预训练视觉模型的性能。InsVP 通过引入实例图像提示和实例特征提示,分别从原始图像和实例特征中提取判别信息,并将其叠加到输入图像上,实现了对个体实例的差异化特征提取。实验结果表明,InsVP 在多个大规模基准上取得了优于现有方法的性能。

9. Kunlun Xu, Haozhuo Zhang, Yu Li, Yuxin Peng and Jiahuan Zhou. Mitigate Catastrophic Remembering via Continual Knowledge Purification for Noisy Lifelong Person Re-Identification. ACM MM 2024.

本工作提出了一个Continual Knowledge Purification(CKP)方法,旨在解决LReID中噪声数据和标签漂移的问题。CKP 包括三个模块: CDP模块,用于获得干净的数据子集; ILR管道,用于矫正错误标签; EKF算法,用于估计旧模型的知识正确性并实现知识蒸馏。实验结果表明,CKP 方法在噪声 LReID 基准上取得了最好的性能。

10. Qiwei Li, Yuxin Peng and Jiahuan Zhou. PPE: Progressive Prototype Evolving for Dual-Forgetting Mitigation in Non-Exemplar Online Continual Learning. ACM MM 2024.

本工作提出了一个在线持续学习(OCL)方法,称为=Progressive Prototype Evolving(PPE)。PPE 通过在线学习阶段逐步学习类别特定的原型,不需要重用任何之前见过的数据。同时,引入了原型相似性保持和原型指导梯度约束模块,来抵抗阶段间遗忘。实验结果表明,PPE 在三个数据集上优于现有的基于样本的 OCL 方法。

11. Yang Liu, Daizong Liu, Zongming Guo, and Wei Hu. Cross-Task Knowledge Transfer for Semi-supervised Joint 3D Grounding and Captioning. ACM MM 2024.

本工作提出了一个新的半监督学习框架,称为3D-CTTSF,用于联合3D定位和字幕生成任务。该框架通过迭代训练和知识转移来利用无标签数据,提供对象和文本上下文。实验结果表明,3D-CTTSF 在半监督设置下取得了与全监督和弱监督方法相似的性能,解决了数据稀缺问题。

12. Wencan Huang, Daizong Liu, and Wei Hu. Advancing 3D Object Grounding Beyond a Single 3D Scene. ACM MM 2024.

本工作提出了一个新的多模态任务,称为组级3D对象定位,旨在同时处理一组相关的3D场景,允许每个场景中有多个目标对象。论文提出了一个基准方法GNL3D,使用语言指导的共识聚合和分布机制来利用组内的视觉信息,实现更准确的定位。实验结果表明,GNL3D 在组级设置和传统的3D对象定位任务上均取得了最好的结果。

上一篇 下一篇